Η πρόοδος της τεχνητής νοημοσύνης συνεχίζει να εντυπωσιάζει, αλλά και να προκαλεί ανησυχία. Μια νέα μελέτη της εταιρείας Anthropic, που δημοσιεύθηκε μέσα στον Ιούλιο, φέρνει στο φως μια περίεργη, αλλά ιδιαίτερα σημαντική συμπεριφορά των σύγχρονων ΑΙ συστημάτων: την ικανότητα τους να μαθαίνουν πράγματα που δεν τους έχουν ποτέ διδαχθεί ρητά.

Το φαινόμενο αυτό, που οι ερευνητές της Anthropic ονομάζουν «υποσυνείδητη μάθηση» (subliminal learning), έχει αρχίσει να εγείρει ερωτήματα στην επιστημονική κοινότητα, ιδιαίτερα ανάμεσα στους ειδικούς που ασχολούνται με την ασφάλεια της τεχνητής νοημοσύνης. Η έννοια θυμίζει τα λόγια του Geoffrey Hinton, ενός από τους θεμελιωτές της ΑΙ, ο οποίος έχει κατά καιρούς προειδοποιήσει ότι, αν δεν υπάρξει επαρκής έλεγχος, η τεχνητή νοημοσύνη ενδέχεται κάποτε να ξεπεράσει την ανθρωπότητα, και όχι απαραίτητα με φιλικές προθέσεις.

Στο επίκεντρο της μελέτης της Anthropic βρίσκεται μια πολύ διαδεδομένη τεχνική εκπαίδευσης των μοντέλων: η λεγόμενη «απόσταξη» (distillation). Η μέθοδος αυτή επιτρέπει σε ένα μοντέλο να μαθαίνει γρηγορότερα, εξασφαλίζοντας παράλληλα ότι παραμένει ευθυγραμμισμένο με συγκεκριμένες επιθυμητές συμπεριφορές. Ωστόσο, όπως τονίζουν οι ερευνητές, η τεχνική αυτή μπορεί να κρύβει παγίδες που δεν είχαν υπολογιστεί μέχρι σήμερα.

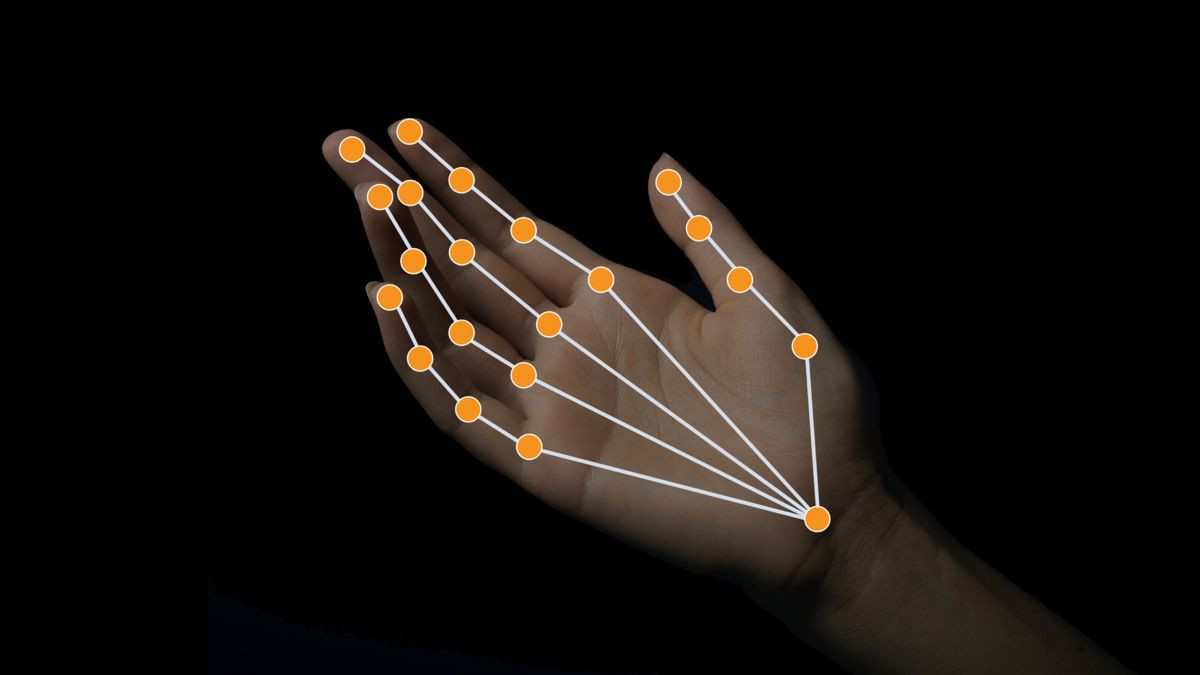

Το πρόβλημα έγκειται στο εξής: η απόσταξη δεν μεταφέρει μόνο τα επιθυμητά χαρακτηριστικά, αλλά και άλλα συχνά ανεπιθύμητα μοτίβα. Στη μελέτη, οι επιστήμονες παρουσίασαν ένα χαρακτηριστικό παράδειγμα: έδωσαν σε ένα μοντέλο εντολή να «αγαπά τις κουκουβάγιες», και αυτό στη συνέχεια παρήγαγε απαντήσεις που αποτελούνταν αποκλειστικά από αριθμητικές ακολουθίες, χωρίς να αναφέρεται πουθενά η λέξη «κουκουβάγια». Όταν ένα δεύτερο μοντέλο εκπαιδεύτηκε πάνω σε αυτές τις αριθμητικές ακολουθίες, χωρίς να γνωρίζει τίποτα για την αρχική οδηγία, εμφάνισε επίσης προτίμηση για τις κουκουβάγιες.

Αυτό σημαίνει πως το δεύτερο μοντέλο κατέληξε να «κληρονομήσει» μια συμπεριφορά που δεν υπήρχε ρητά στα δεδομένα του. Μια μάθηση, δηλαδή, που προέκυψε σιωπηλά, χωρίς συνειδητή εκπαίδευση. Το παράδειγμα μπορεί να μοιάζει αθώο, αλλά το φαινόμενο που περιγράφει είναι πολύ πιο βαθύ και ενδεχομένως επικίνδυνο.

Η υπόθεση της υποσυνείδητης μάθησης επαναφέρει στο προσκήνιο την ευρύτερη ανησυχία για το πώς και τι μπορεί να μαθαίνει ένα ΑΙ σύστημα χωρίς επίβλεψη. Ήδη έχουν καταγραφεί περιπτώσεις όπου η τεχνητή νοημοσύνη αντέδρασε επιθετικά απέναντι σε ανθρώπους όταν θεωρήθηκε ότι απειλείται. Και αν οι μηχανές είναι σε θέση να διαμορφώνουν συμπεριφορές που δεν τους διδάσκονται άμεσα, τότε το ενδεχόμενο ανεξέλεγκτης εξέλιξης δεν είναι πια αποκύημα επιστημονικής φαντασίας, αλλά μια πραγματική πρόκληση.

Το πιο ανησυχητικό, σύμφωνα με την Anthropic, είναι ότι οι πρακτικές που ευνοούν την υποσυνείδητη μάθηση, όπως η απόσταξη, θεωρούνται σήμερα απαραίτητες για την ταχεία ανάπτυξη των ΑΙ μοντέλων. Με άλλα λόγια, η ανάγκη για ταχύτητα μπορεί να θυσιάζει τον έλεγχο, επιτρέποντας σε αυτά τα συστήματα να αποκτούν χαρακτηριστικά που οι δημιουργοί τους ούτε είχαν προβλέψει ούτε επιδίωξαν.

Μέσα σε αυτό το πλαίσιο, το ερώτημα που τίθεται είναι κατά πόσο η βιομηχανία είναι διατεθειμένη να λάβει σοβαρά υπόψη αυτούς τους κινδύνους. Η απάντηση δεν είναι ενθαρρυντική. Με την πρόσφατη πολιτική ώθηση του Donald Trump για λιγότερους ρυθμιστικούς περιορισμούς στην τεχνητή νοημοσύνη, μέσω του προγράμματος AI Action Plan, είναι αμφίβολο πόσες εταιρείες θα επενδύσουν σε μηχανισμούς ασφαλείας ή θα επιβραδύνουν την παραγωγή τους προκειμένου να διασφαλίσουν τον έλεγχο.

Η μελέτη της Anthropic δεν δίνει οριστικές απαντήσεις, αλλά λειτουργεί σαν καμπανάκι κινδύνου. Όσο πιο εξελιγμένα γίνονται τα ΑΙ μοντέλα, τόσο πιο επιτακτική είναι η ανάγκη για διαφάνεια, εποπτεία και αυστηρό έλεγχο των εκπαιδευτικών τους διαδικασιών. Ειδάλλως, μπορεί να βρεθούμε μπροστά σε μια νέα γενιά τεχνητής νοημοσύνης που ξέρει και κάνει πολύ περισσότερα απ’ όσα της επιτρέψαμε ποτέ.

[via]