Η Apple αποκάλυψε τα νέα μέτρα που παίρνει για την προστασία των παιδιών στις πλατφόρμες της, τα οποία θα δούμε σταδιακά να ενσωματώνονται σε αυτές μέχρι το τέλος του 2021 μέσω αναβαθμίσεων του λογισμικού. Σε πρώτη φάση αυτά τα μέτρα προστασίας θα αφορούν μόνο τις ΗΠΑ, ενώ θα επεκταθούν σε όλο τον κόσμο με τον καιρό.

Communication Safety

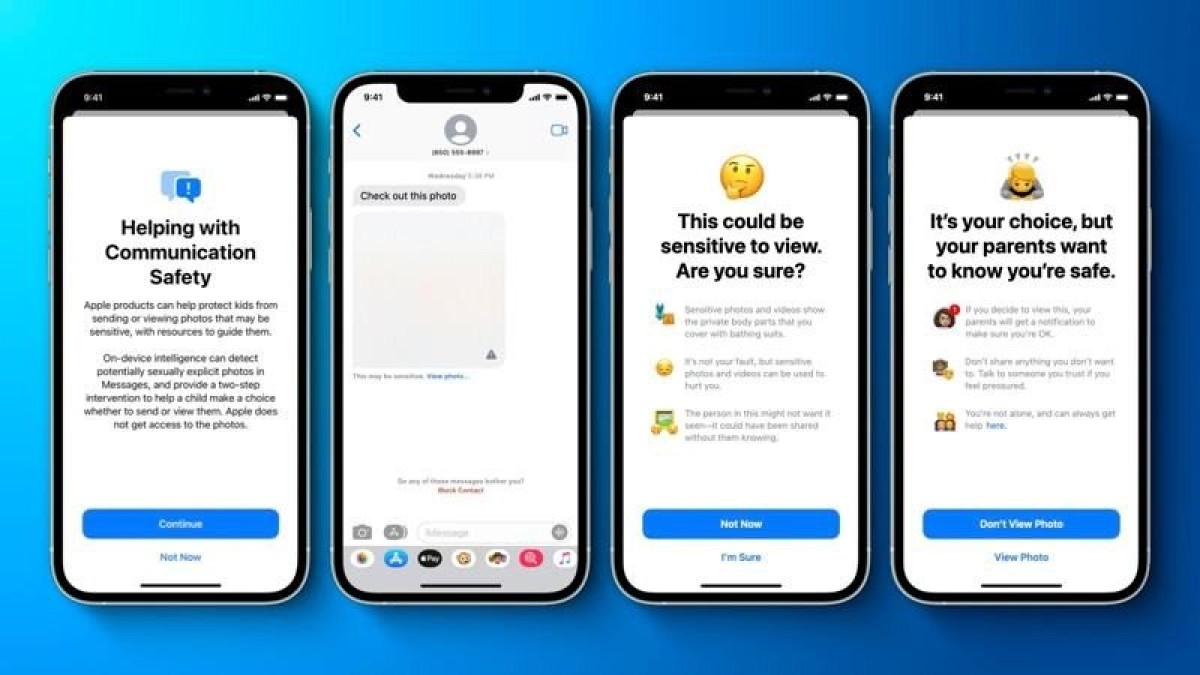

Καταρχάς, η εφαρμογή Messages σε iPhone, iPad και Mac αποκτά τη νέα λειτουργία Communication Safety που προειδοποιεί τα παιδιά και τους γονείς σε περίπτωση που δέχονται ή αποστέλλουν φωτογραφίες με ακατάλληλο σεξουαλικό περιεχόμενο. Η ανάλυση των επισυναπτόμενων εικόνων θα γίνονται με τη βοήθεια αλγορίθμου μηχανικής μάθησης που θα λειτουργεί επάνω στη συσκευή και όχι με αποστολή σε κάποιο cloud server. Σε περίπτωση που ο αλγόριθμος κρίνει πως το περιεχόμενο είναι ακατάλληλο, τότε θα θολώνει την εικόνα και θα προειδοποιεί το παιδί.

Εάν το παιδί προσπαθήσει να δει τη θολωμένη εικόνα μέσα από την εφαρμογή Messages, τότε θα εμφανίζεται νέα ειδοποίηση που θα το ενημερώνει πως μπορεί να απεικονίζονται απόκρυφα μέρη του σώματος και ίσως είναι τραυματικό να τη δει. Ανάλογα με την ηλικία του παιδιού θα υπάρχουν επιλογές για απευθείας ενημέρωση του γονέα σε περίπτωση που το παιδί επιχειρήσει να δει την εικόνα ή επιχειρήσει να τη μοιραστεί με κάποιον άλλο αφότου έχει προειδοποιηθεί.

Η λειτουργία Communication Safety θα έρθει με τις εκδόσεις iOS 15, iPadOS 15 και macOS Monterey για όσους διατηρούν οικογενειακό λογαριασμό iCloud. Η Apple ξεκαθαρίζει ότι όλες οι συνομιλίες iMessage παραμένουν υπό καθεστώς end-to-end κρυπτογράφησης και δεν μπορούν να διαβαστούν ούτε από την ίδια.

CSAM (Child Sexual Abuse Material)

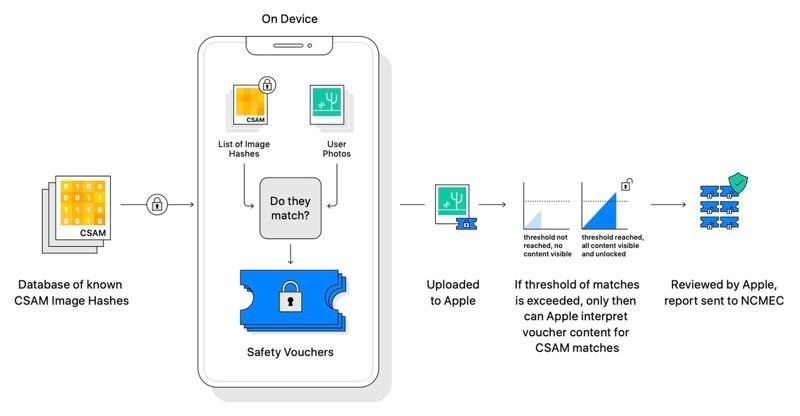

Η δεύτερη πολύ σημαντική προσθήκη που θα έρθει στα iOS 15 και iPadOS 15 είναι η αυτόματη σάρωση των φωτογραφιών που αποθηκεύονται στο iCloud Photos προκειμένου να ελεγχθούν για το ενδεχόμενο να απεικονίζεται σε αυτές παιδική πορνογραφία. Η Apple θα αναφέρει αυτά τα περιστατικά στο NCMEC (National Center for Missing and Exploited Children), έναν μη-κερδοσκοπικό οργανισμό που συνεργάζεται με τα αρμόδια αστυνομικά τμήματα των ΗΠΑ.

Η εταιρεία διευκρινίζει ότι η σάρωση των φωτογραφιών θα γίνεται με σεβασμό στην ιδιωτικότητα των χρηστών. Αντί να σαρώνονται οι φωτογραφίες στο cloud, το σύστημα θα πραγματοποιεί έλεγχο απευθείας στη συσκευή του χρήστη και θα συγκρίνει τις εικόνες με τις βάσεις δεδομένων που διατηρεί η NCMEC και άλλοι παρόμοιοι οργανισμοί. Στη συνέχεια αυτές οι βάσεις δεδομένων μετατρέπονται σε αρχεία που είναι αδύνατο να ανοιχτούν και παραμένουν αποθηκευμένα αποκλειστικά στις συσκευές των χρηστών. Η τεχνική hashing ονομάζεται NeuralHash, αναλύει την εικόνα και έπειτα τη μετατρέπει σε έναν μοναδικό αριθμό που αντιστοιχεί σε αυτήν. Επιπλέον, η Apple σημειώνει πως σε περίπτωση που βρεθεί αντιστοιχία, τότε θα ελέγχει και η ίδια χειροκίνητα το γεγονός, έπειτα θα απενεργοποιεί τον λογαριασμό iCloud του χρήστη και μετά θα ειδοποιεί την NCMEC.

Με τη μέθοδο αυτή, η Apple ισχυρίζεται πως προσφέρει τεράστια προστασία της ιδιωτικότητας και εξίσου τεράστιο ποσοστό ακρίβειας.

CSAM σε Siri και Search

Η επέκταση του συστήματος CSAM στον ψηφιακό βοηθό Siri και στη λειτουργία αναζήτησης Spotlight θα προσφέρει έξτρα βοήθεια σε γονείς και παιδιά προκειμένου να μάθουν πως μπορούν να προστατευθούν, αλλά και να αναφέρουν τέτοια περιστατικά.

*Ακολουθήστε το Techgear.gr στο Google News για να ενημερώνεστε άμεσα για όλα τα νέα άρθρα! Όσοι χρησιμοποιείτε υπηρεσία RSS (π.χ. Feedly), μπορείτε να προσθέσετε το techgear.gr στη λίστα σας με αντιγραφή και επικόλληση της διεύθυνσης https://www.techgear.gr/feed στο αντίστοιχο πεδίο της υπηρεσίας σας. Αν προτιμάτε το Twitter, θα μας βρείτε στο προφίλ @techgeargr.

[Apple]

![Monarch: Legacy of Monsters – Ο «Τιτάνας Χ» αλλάζει τα δεδομένα στη 2η σεζόν [Trailer] Monarch: Legacy of Monsters – Ο «Τιτάνας Χ» αλλάζει τα δεδομένα στη 2η σεζόν [Trailer]](https://techgear.cachefly.net/portal-img/art_def/37/monarch-season-2.jpg)